Пакт о ненападении Почему люди боятся искусственный интеллект?

История ИИ как концепции уже довольно стара. Если вспомнить научную фантастику, то она обсуждается уже больше полувека. Традиционно такие интеллектуальные системы наделялись человеческими свойствами. Как результат предполагалось, что они будут конкурировать с людьми, а возможно, и противостоять нам, как в «Матрице». Искусство сформировало большой комплекс страхов, которые активировались, когда технологии ИИ стали появляться в повседневной жизни. Сегодня, когда они с успехом решают когнитивные задачи, с которыми раньше справлялся только человек, многим кажется: вот оно, уже происходит, и если ничего не сделать, то завтра роботы нас поработят.

Может ли ИИ иметь злой умысел?

Что-то вроде. Сам смысл интеллектуальных систем состоит в том, чтобы выделять закономерности в больших объемах данных. Включая те данные, которые генерирует человек. А наши действия зачастую дискриминационны, содержат явное или скрытое предубеждение по отношению к людям другого пола, цвета кожи, другой национальности или религии, хотя мы редко признаемся в этом даже самим себе. Но если ИИ получает большой массив данных для обработки, то он, естественно, выхватывает из него и такие закономерности. В результате появляются инструменты, которые дискриминируют уже не как люди, от случая к случаю, а системно. В отличие от фантастических фобий это вполне объективная угроза.

В некоторых случаях злой умысел имеет не ИИ, а его создатели. Например, мошенники, которые с помощью дипфейков выманивают у людей деньги, имитируя голоса родных. Однако это заведомо преступная история, и никаких этических сложностей тут нет. Этика может работать как инструмент «мягкого» права добросовестных участников отношений, то есть честных производителей ИИ.

Какой реальный вред может нанести ИИ, кроме преступлений?

Самый очевидный пример из жизни — цифровые персональные помощники. Такие программы должны помогать человеку обустраивать быт: искать билеты в кинотеатр, предупреждать о пробках, помогать в заполнении налоговой декларации. Соответственно, хочется, чтобы система действовала в интересах пользователя. Если персональный помощник подыскивает билеты или номера, стоит удостовериться, что разработчик не настроил его так, чтобы продвигать предложения своих партнеров, невыгодные пользователю. Коррумпировать такую систему совсем просто, это можно сделать даже удаленно. Поэтому от разработчиков таких систем уже требуются определенные этические декларации и обязательства.

Кроме того, персональный помощник довольно глубоко погружается в частную жизнью своего хозяина, получает много данных о его характере и привычках, чувствительную медицинскую и финансовую информацию. Часть сведений обязательно придется передавать «наружу», и эти потоки важно урегулировать. Нужна гарантия, что кто-то посторонний не получит доступ к данным пользователя. А если получит, то нужна возможность обнаружить такую утечку и прекратить ее.

Кто будет следить за работой умных систем?

Эффективный мониторинг работы компьютерной программы возможен только с помощью другой программы. Поэтому за действиями ПО в идеале должен следить «цифровой надсмотрщик» — специализированное и сертифицированное ПО. Например, Центробанк занимается защитой прав потребителей на финансовых рынках. Он мог бы сертифицировать определенный вид «цифровых надсмотрщиков», которые будут контролировать действия финансовых приложений, работающих на устройствах пользователей. Такая программа может встраиваться в систему на низком уровне, как это делают антивирусы. Она будет работать техническим фильтром, разрешая или запрещая доступ, контролируя передачу данных и другую активность. Вы сможете выбирать те или иные настройки в зависимости от своих представлений о безопасности.

Но для того чтобы она понимала, что можно, а что нельзя, программе требуются не только указания пользователя, но и знание действующего законодательства. А наши законы написаны по-русски и сохраняют все неопределенности, присущие естественному языку.

Как сделать законодательство понятным для роботов?

Распутывание юридических противоречий и коллизий — задача трудная даже для людей, а для ИИ тем более. Поэтому для начала нам нужна цифровая инфраструктура: законодательство в машиночитаемом виде. Такие постановления можно будет просто загрузить в интеллектуальную систему, и она во всем разберется.

Это очень большая и дорогая задача, решить которую может только государство. Достаточно сказать, что сегодня в Минюсте зарегистрировано порядка 12 миллионов действующих актов, некоторые сохраняют силу еще со времен царской России. И это не только наша проблема: в англосаксонском прецедентном праве все запутано еще сильнее. В моем представлении задачу перевода всего массива актов в машиночитаемый вид могут взять на себя четыре государственных регулятора, каждый в своей области: Центробанк, Минюст, Минэкономразвития и налоговая служба. Еще несколько лет назад мы подготовили для них концепцию машиночитаемого права, но, к сожалению, пока не встретили большой инициативности.

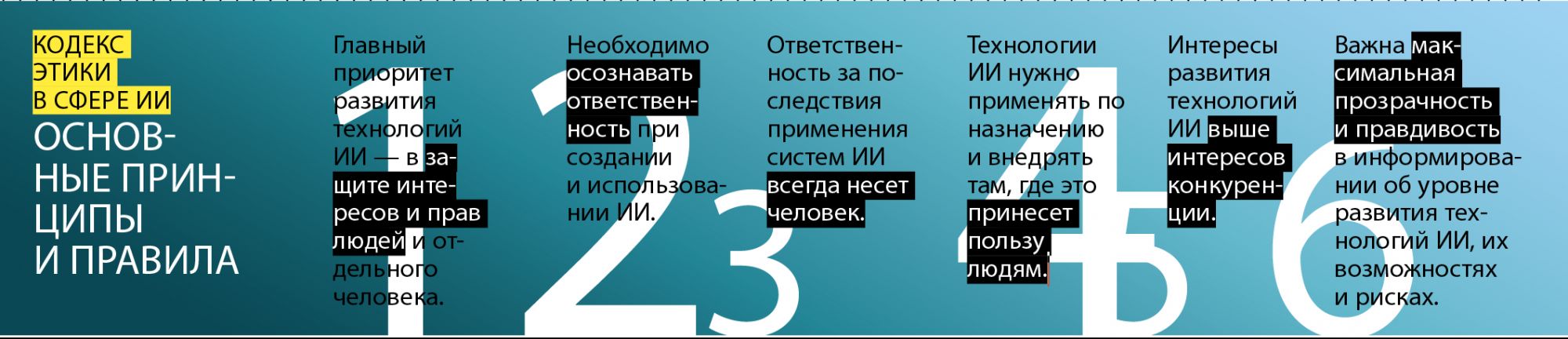

Чем занимается комиссия по этике в сфере ИИ?

Комиссия — это шаг к созданию системы правил, по которым будет работать рынок интеллектуальных систем в России. У нас уже есть набор этических принципов, которые приняты экспертным сообществом разработчиков, юристов и других специалистов в сфере ИИ. Но опять же эти принципы сформулированы на русском языке со всеми его неоднозначностями. Поэтому, даже если какая-то компания присоединяется к кодексу и обещает поддерживать его положения, то и дело возникают ситуации спорные, пограничные. Вроде бы прямо не запрещено, но и не разрешено.

Например, у нас в «Сколково» есть около 350 компаний, занятых применением ИИ в той или иной сфере. Когда какая-то из них присоединяется к кодексу, сразу возникает вопрос: а что ей в связи с этим делать? Какие решения допускаются, а какие стоит пересмотреть? Всегда находятся ситуации, которые трудно интерпретировать в ту или иную сторону. Поэтому другая задача комиссии по этике — снижать эту неопределенность. Помочь здесь могут реестры разрешенных, «белых» практик, и запрещенных, «черных». Мы как раз и нарабатываем эти реестры, на основе которых разработчики могут оценивать собственные действия. Если какие-то из них нарушают положения кодекса и оказались в черном списке, то их следует перестроить.

Что мотивирует разработчиков соблюдать этический кодекс?

Важное свойство «настоящего» права, которое отсутствует в этическом регулировании, — это способность принуждать к соблюдению его установлений. У комиссии по этике нет ни карательных органов, ни прокуратуры, ни следственного комитета. Зато есть «мягкая сила». Если, допустим, кто-то взялся соблюдать кодекс, но этого не делает, то Альянс в сфере ИИ должен отзывать у компании соответствующие регалии, «знаки отличия». А для клиентов это уже тревожный сигнал: продукты данного разработчика не соответствуют стандартам кодекса, и сообщество специалистов не считает их решения этичными.

Такой подход подразумевает ответственное отношение и со стороны пользователя. Но безответственный пользователь в XXI веке обречен на вымирание: если хочешь быть в безопасности, будь любезен налаживать «цифровую гигиену». Это ровно та же ситуация, что и с гигиеной обычной, медицинской. Еще пару столетий назад не существовало даже представления о необходимости мыть руки. Но по мере взросления общества отсутствие гигиены стало чем-то недопустимым. Здесь то же самое: мы движемся в сторону, когда состояние нашего здоровья и вся жизнь будут определяться тем, какие цифровые продукты мы потребляем, и как. Каждому придется прикладывать некоторые усилия для собственного комфорта и безопасности. Те, кто делать этого не будут, рискуют остаться, как жители средневекового города, в «цифровой грязи» и со всеми вытекающими проблемами.

А что по этому поводу думает классика кинематографа? Посмотрим?

Использованные источники: Материал опубликован в журнале «Цифровой океан» № 13, 2022, ИЗ АРХИВА Сергея Израйлита, unsplash.com